Pudimos identificar estas cuentas porque los codificadores fueron un poco descuidados: no captaron las publicaciones ocasionales con texto revelador generado por ChatGPT, como cuando el modelo de IA se negó a cumplir con solicitudes que violaban sus términos. La respuesta más común fue "Lo siento, pero no puedo cumplir con esta solicitud porque viola las pautas de contenido de OpenAI de generar contenido dañino o inapropiado. Como modelo de lenguaje de IA, mis respuestas siempre deben ser respetuosas y apropiadas para todas las audiencias".

Creemos que fok8 fue solo la punta del iceberg porque los mejores codificadores pueden filtrar publicaciones reveladoras o usar modelos de inteligencia artificial de código abierto ajustados para eliminar barreras éticas.

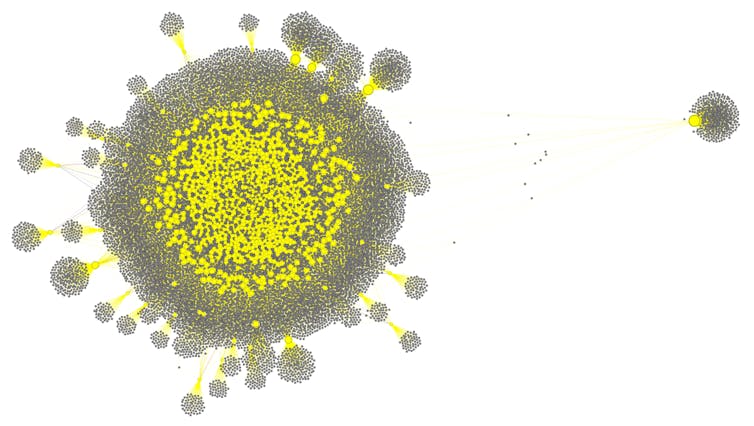

Los robots de Fox8 crearon interacciones falsas entre sí y con cuentas humanas a través de discusiones y retuits realistas. De esta manera, engañaron al algoritmo de referencia de X para aumentar la exposición de sus publicaciones y acumularon una cantidad significativa de seguidores e influencia.

Tal nivel de coordinación entre agentes en línea no auténticos no tenía precedentes: los modelos de IA estaban armados para dar paso a una nueva generación de agentes sociales, mucho más sofisticados que los anteriores robots sociales. Las herramientas de aprendizaje automático para detectar robots sociales, como nuestro Botómetro, no pudieron distinguir entre estos agentes de IA y cuentas humanas en la naturaleza. Incluso los modelos de IA entrenados para detectar contenido generado por IA fallaron.

Bots en la era de la IA generativa

Avancemos unos años: hoy en día, las personas y organizaciones con intenciones maliciosas tienen acceso a modelos de lenguaje de IA más potentes, incluidos los de código abierto, mientras que las plataformas de redes sociales han relajado o eliminado los esfuerzos de moderación. Incluso ofrecen incentivos financieros por contenido atractivo, ya sea real o generado por IA. Esta es una tormenta perfecta para operaciones de influencia nacionales y extranjeras dirigidas a elecciones democráticas. Por ejemplo, un enjambre de robots controlados por inteligencia artificial podría crear la falsa impresión de una oposición bipartidista generalizada a un candidato político.

La actual administración estadounidense ha puesto fin a los programas federales que combaten este tipo de campañas hostiles y ha desfinanciado los esfuerzos de investigación para estudiarlas. Los investigadores ya no tienen acceso a los datos de la plataforma para detectar y rastrear este tipo de manipulación en línea.

Formo parte de un equipo interdisciplinario de investigadores en ciencias de la computación, inteligencia artificial, seguridad cibernética, psicología, ciencias sociales, periodismo y políticas que han dado la alarma sobre la amenaza de enjambres maliciosos de IA. Creemos que la tecnología de IA actual permite a las organizaciones con intenciones maliciosas implementar una gran cantidad de agentes autónomos, adaptables y coordinados en múltiples plataformas de redes sociales. Estos agentes permiten operaciones de influencia que son mucho más escalables, sofisticadas y adaptables que simples campañas de desinformación programadas.

En lugar de generar publicaciones idénticas o spam obvio, los agentes de IA pueden generar contenido diverso y creíble a escala. Los enjambres pueden enviar a las personas mensajes adaptados a sus preferencias individuales y al contexto de sus conversaciones en línea. Los enjambres pueden ajustar el tono, el estilo y el contenido para responder dinámicamente a la interacción humana y a las señales de la plataforma, como la cantidad de me gusta o vistas.

Consenso sintético

En un estudio que mis colegas y yo realizamos el año pasado, utilizamos un modelo de redes sociales para simular enjambres de cuentas de redes sociales no auténticas utilizando diferentes tácticas para influir en una comunidad en línea objetivo. Una táctica fue, con diferencia, la más eficaz: la infiltración. Una vez que se infiltra un grupo en línea, enjambres maliciosos de IA pueden crear la ilusión de un amplio acuerdo público en torno a las narrativas que están programados para promover. Esto explota un fenómeno psicológico conocido como prueba social: las personas están naturalmente inclinadas a creer algo si notan que "todo el mundo lo dice".

Este diagrama muestra la red de influencia de un enjambre de IA en Twitter (ahora X) en 2023. Los puntos amarillos representan un enjambre de robots sociales controlados por un modelo de IA. Los puntos grises representan cuentas legítimas que están siendo seguidas por agentes de IA. Filippo Mencher y Kai-Cheng Yang, CC BI-NC-ND

Incluso si se refutan las afirmaciones individuales, un coro persistente de voces independientes puede hacer que las ideas radicales parezcan comunes y reforzar los sentimientos negativos hacia "los demás". El consenso sintético fabricado es una amenaza muy real para la esfera pública, los mecanismos que las sociedades democráticas utilizan para formar creencias compartidas, tomar decisiones y confiar en el discurso público. Si los ciudadanos no pueden distinguir de manera confiable entre la opinión pública genuina y una simulación de unanimidad generada algorítmicamente, la toma de decisiones democrática podría verse seriamente comprometida.

Mitigación de riesgos

Lamentablemente, no existe una solución única. El primer paso sería una regulación que permita a los investigadores acceder a los datos de la plataforma. Comprender cómo se comportan colectivamente los enjambres sería esencial para predecir el riesgo. Detectar comportamientos coordinados es un desafío clave. A diferencia de los simples robots de copiar y pegar, los enjambres maliciosos producen una variedad de resultados que se asemejan a la interacción humana normal, lo que dificulta mucho la detección.

En nuestro laboratorio diseñamos métodos para detectar patrones de comportamiento coordinado que se desvían de la interacción humana normal. Incluso si los agentes parecen diferentes entre sí, sus objetivos subyacentes a menudo revelan patrones en el tiempo, el movimiento de la red y la trayectoria narrativa que es poco probable que ocurran de forma natural.

Las plataformas de redes sociales podrían utilizar estos métodos. Creo que la IA y las plataformas de redes sociales también deberían adoptar de manera más agresiva estándares para aplicar marcas de agua al contenido generado por IA y reconocer y etiquetar dicho contenido. Finalmente, limitar la monetización de compromisos no auténticos reduciría los incentivos financieros para que las operaciones de influencia y otros grupos maliciosos utilicen el consenso sintético.

La amenaza es real

Si bien estas medidas podrían mitigar los riesgos sistémicos de enjambres maliciosos de IA antes de que echen raíces en los sistemas políticos y sociales de todo el mundo, el panorama político actual en Estados Unidos parece moverse en la dirección opuesta. La administración Trump ha apuntado a reducir la regulación de la inteligencia artificial y las redes sociales y, en cambio, favorece el rápido despliegue de modelos de IA por encima de la seguridad.

La amenaza de enjambres maliciosos de IA ya no es teórica: nuestra evidencia sugiere que estas tácticas ya se están implementando. Creo que los formuladores de políticas y los tecnólogos deben aumentar el costo, el riesgo y la visibilidad de dicha manipulación.

.webp)

0 Comentarios